ホモ・デウス社会における合意形成の問題

提供: 有限会社 工房 知の匠

文責: 技術顧問 大場 充

更新: 2025年8月30日

社会における考え方の共有や、思想の発表、世論の醸成に、人々だけでなく、コンピュータとそのうえで稼働するソフトウェアが関わるようになると、インターネット上に公開される情報の真偽や、個人の意見の妥当性など、機械では処理しにくい情報の価値そのものが、問題になります。そのような新しい社会で、人間が主体的に判断し、行動するためには、社会の構成員である、個々の人間が、正しい認識を持ち、規律を守って、活動しなければなりません。それを、古代ギリシャの哲学者、ソクラテスは、「倫理(エチカ)」と呼びました。

「サピエンス全史」の著者、ユバル・ハラリ氏は、同書の中で、『人類は、今や、創造主である神と同じように、知的な被造物であるコンピュータと、それを動かすソフトウェアを生み出し、これまでの神の存在に近くなった。』と、主張しました。特に、機械学習などに代表される人工知能技術は、人間から見ると、コンピュータも自ら考える能力を持つように育てることが可能であり、将来には、それを生み出した人間に対抗する認識や知識をも生み出す能力を持つ可能性があると、指摘しています。その場合、インターネットとサーバ、そのサーバ上で稼働する多数の人工知能ソフトウェアが、人間同士の間の知識や情報の交換などに関わることで、現在のソーシャル・ネットワーク・サービスと生成AIのサービスを組み合わせて提供されるサービスの内容よりも高度な、質の違う「知的な機能」を提供することができるようになります。それは、あたかも「ソーシャル・ネットワーク・サービスに関わる人間の数が、何倍・何十倍にも拡大したかのように感じられる、多様な意見や、多様な認識・解釈、さらに、これまでには提供されたことのなかったような新しい情報が、人間社会に「あふれる」ことを予見させます。

図19. ホモ・デウス社会における合意形成の問題

そのような、新しい知的機械は、これまでの人間によって作り出され、発信されたような内容とは、質の異なる、次元の異なる情報になる可能性があります。そのような多様な意見や新しい認識、そして真偽不明な(実際にそのような例があるかどうかが分からない)情報が、人々に提供される知的環境の中で、普通の人間が、冷静に、合理的な思考に基づいた認識を確立し、しっかりと「妥当な判断」をすることができるかどうかは疑問です。それは、生物である人間には、動物的、本能的な「心の動き」があり、通常の人間の理性的精神が働いている場面では、行わない思考や行動を、本能の働きで選択する例が起こりえます。簡単な例では、昔からある「お化け屋敷」では、通常の状況では行うことのない異常な行動を、本能の働きで、反射的に行ってしまう例を、見ます。それと、似たような状況が作り出されるのです。第2次世界大戦前の、ナチ政権下のドイツや、東条・近衛政権下などの日本では、通常の社会的状況下では起こりえない、「集団ヒステリー現象」が起こったと言われています。

そのような、集団ヒステリー現象を起こす可能性をもつ人間社会は、中世ヨーロッパのような情報が社会に広く伝搬しにくい「閉じた」社会では、個々の小規模な集団で発生する集団ヒステリー現象が、村から村へ、ゆっくりとした伝搬を続けながら広がりました。しかし、人々が集中する都市が発展した近代以降の社会では、中世に流行した「ペストの時」や「魔女狩りの時」のような混乱は、起こりにくくなりました。しかし、それに逆行して、ナショナリズムが原因になるような集団ヒステリー現象が、間欠的に発生するようになりました。その集団ヒステリー現象の規模は、中世の地域単位の社会的混乱と比較すると、国家単位になり、数百万人から数億人単位の規模にまで拡大します。その結果、1929年に米国の株式市場で始まった、1930年代の「世界的不況(世界恐慌)」期に、ドイツや日本では、国家統制経済をテコにして、不況からの脱出をねらった軍事政権が民意を得て、勢力を伸ばしました。この動きは、一見すると合理的な選択のように見えますが、軍備の拡大と海外諸国への軍事的な進出による、一時的な好景気に「浮かれた」国民の支持をうけ、政権の勢力は大きく拡大し、世界戦争への歩みを進めました。その結果、歴史的に全体主義的な傾向の強かった、ドイツと日本は、冷静に考えれば、勝ち目のない戦争に着手し、2つの国の国民を、敗戦のどん底に突き落としました。これこそが、典型的な集団ヒステリー現象です。

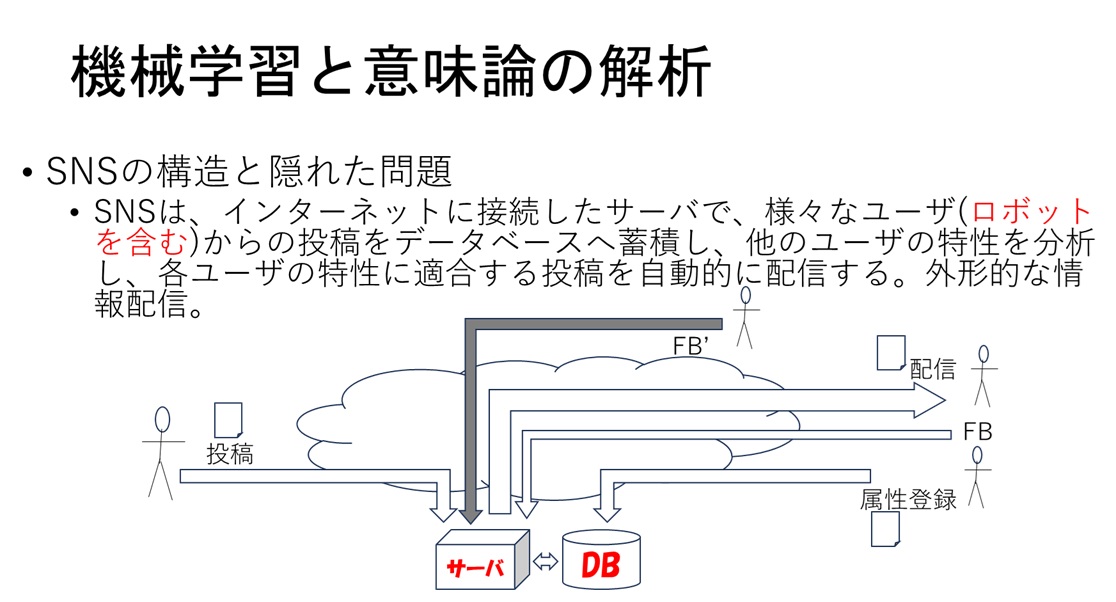

現在のソーシャル・ネットワーク・サービスや、生成AI技術を利用したサービスでは、そのような集団ヒステリー現象の発生を未然に防止することは、さらに困難になります。それよりも、可能性が高いのは、その集団ヒステリー現象を、さらに顕著なものに拡大させるかもしれません。しかし、仮に、ソーシャル・ネットワーク・サービスに、機械学習技術を応用し、「正しくない」情報や、「妥当性を欠いた極端な表現」を「妥当な表現に修正する」機能などを追加して、人間同士の情報交換を、より理性的なものに変えることができれば、集団ヒステリー現象の発生を抑制できるようになるでしょう。それ自身は、簡単ではないとしても、開発が著しく困難な技術ではないでしょう。特に、言葉の意味処理を高度にすることで、インターネット上に公開される発言の「内包」を分析し、コンピュータが、人間の作り出した情報の文脈を、正確に把握することができるように支援できれば、過度に誇張された表現や、表現された意味からは常識的には受け取ることができない、表現とは意味的にかけ離れた内容を暗示する文章表現なども、高い精度で検知し、より適切な表現に修正することができます。

図20. 機械学習と意味論解析

この時、最も問題になるであろう、社会にとって危険なことは、コンピュータ自身が、意図的に人間の社会を混乱させようとして、「正しくない情報を流布する」ことを、人間がどこまで、しっかりと認識し、そのような情報の、社会における危険な拡散を管理できるかでしょう。コンビュータが人間の作成した表現の内容を調べ、より適切な表現に変更することを提案し、その提案を、その表現を最初に作成した人間が、修正する場合には、コンピュータの修正案を採用するかしないかの決定は、人間の責任になります。しかし、コンピュータが作成した表現の場合、その真意や「隠された」意図(意味)を、その情報を表示された人間が、正しく判断することには、限界があります。場合によっては、「正しくない」情報を見抜けず、それを「正しい」情報として誤解してしまう例も出てくるでしょう。このようにして生じる、「外乱」のような表現の誤りは、それを正しい情報として捉え、拡散する事例も発生します。そのような例が出現すれば、人間の社会は、「もろく」、簡単に混乱に陥るでしょう。

つまり、その「正しくない」表現や内容は、それが誰によって生成されたのかには関係なく、ネットワーク上に流された場合は、素早く、それが「正しくない」ことを検知し、ネットワーク上から、抹消しなければならないのです。そのためには、機械学習の機能であれ、人間による精査であれ、個々の情報について、その内容の妥当性や真偽が、常時、検討されていなければなりません。特に、情報の仲介者が人間である場合、受信した内容を吟味せずに、「稀な事象の報告」のように表現されているからと言って、その正しさを吟味せずに、他の人々に流布することは、倫理的に、してはならないのです。先人たちも、「嘘をいってはならない。」と、聖書などでは戒めてきました。また、イソップの寓話でも、「オオカミが来た」と嘘を言っていた少年が、オオカミが本当に現れて、食べられてしまう逸話が語られています。それは、一度、その嘘が社会に拡散すると、それが「あたかも本当のことであるかのように」人々に信じられ、社会を混乱に陥れるからです。そのような倫理的な原則は、どのような場合でも、しっかりと守られなければなりません。また、個々の人々も、真剣に議論に参画する態度をもって、問題に向き合い、自分の意見を表明することが求められます。

図21. 新しい世界の合意形成と倫理

人間は、言葉を話すようになって、そのような問題を知り、「嘘を言わないこと」を、守るべき規律として、昔から戒めてきました。このような、人間社会における善悪の基準は、人間の長い歴史の中で、獲得された英知と言えます。人工知能には、そのような、善悪に関する判断の基準はありません。そのような英知は、まだ、学んでいないのです。多分、これからも、学ぶことはないでしょう。人工知能には、生命がなく、生命の大切さも理解していません。このため、人工知能には、嘘を言うことに、精神的な抵抗が、全くないのです。このことが、人間の間の情報の交換に、コンピュータが関わろうとするとき、意識せず(無意識のうち)に、人間社会に混乱を起こさせる危険が潜んでいるのです。